Youtube anunció hoy que está lanzando una nueva función que impulsará a los comentaristas a reconsiderar sus comentarios ofensivos y de odio antes de publicarlos. También comenzará a probar un filtro que permite a los creadores evitar tener que leer algunos de los comentarios hirientes en su canal que se habían retenido automáticamente para su revisión. Las nuevas funciones están destinadas a abordar problemas de larga data con la calidad de los comentarios en la plataforma de YouTube, un problema del que los creadores se han quejado durante años.

La compañía dijo que pronto también realizará una encuesta destinada a brindar igualdad de oportunidades a los creadores, y cuyos datos pueden ayudar a la compañía a comprender mejor cómo algunos creadores se ven afectados de manera más desproporcionada por el odio y el acoso en línea.

La nueva función de comentarios, lanzada hoy, es un cambio significativo para YouTube.

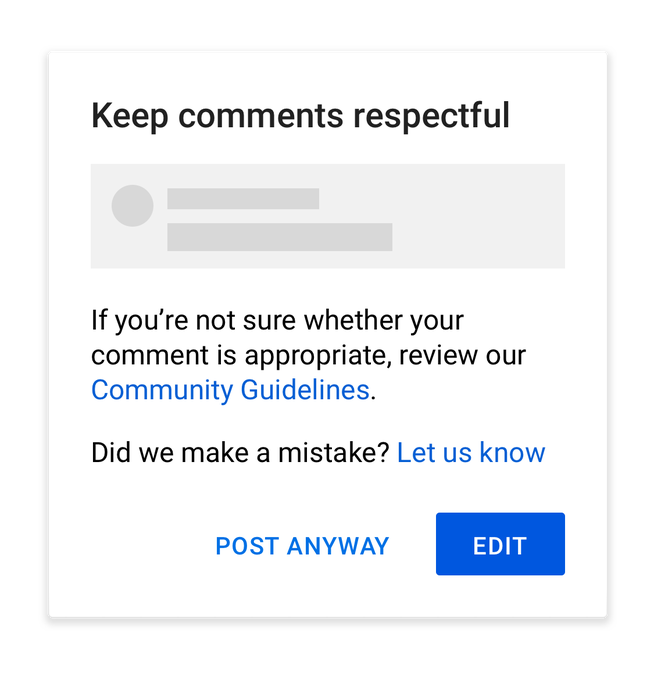

La función aparece cuando los usuarios están a punto de publicar algo ofensivo en la sección de comentarios de un video y advierte “Mantenga los comentarios respetuosos”. El mensaje también les dice a los usuarios que revisen las Pautas de la comunidad del sitio si no están seguros de si un comentario es apropiado.

La ventana emergente luego empuja a los usuarios a hacer clic en el botón “Editar” y revisar su comentario haciendo que “Editar” sea la opción más prominente en la pantalla que aparece.

Sin embargo, la función no evitará que un usuario publique su comentario. Si quieren continuar, pueden hacer clic en la opción “Publicar de todos modos”.

Créditos de imagen: Youtube

La idea de poner obstáculos para que los usuarios tengan tiempo para hacer una pausa y reconsiderar sus palabras y acciones es algo que varias plataformas de redes sociales están haciendo ahora.

Por ejemplo, Instagram lanzó el año pasado una función que marcaría los comentarios ofensivos antes de que se publicaran. Más tarde lo amplió para incluir subtítulos ofensivos. Sin proporcionar datos, la empresa afirmó que estos “empujones” estaban ayudando a reducir el acoso en línea. Mientras tanto, este año Twitter comenzó a presionar a los usuarios para que leyeran el artículo vinculado en los tweets que estaban a punto de compartir antes de tuitear su reacción, e impidió que los usuarios pudieran retuitear con un solo clic.

Estas pausas intencionales integradas en las plataformas sociales están diseñadas para evitar que las personas reaccionen al contenido con mayor emoción e ira y, en cambio, empujen a los usuarios a ser más reflexivos en lo que dicen y hacen. Los cambios en la interfaz de usuario como este aprovechan la psicología humana básica para funcionar, e incluso pueden resultar efectivos en algún porcentaje de los casos. Pero las plataformas han dudado en implementar tales ajustes, ya que pueden sofocar la participación de los usuarios.

En el caso de YouTube, la compañía le dice a TechCrunch que sus sistemas aprenderán qué se considera ofensivo en función del contenido que los usuarios marcan repetidamente. Con el tiempo, este sistema impulsado por IA debería poder mejorar a medida que la tecnología mejora en la detección y el sistema en sí se desarrolla aún más.

Los usuarios de Android en el idioma inglés verán primero las nuevas indicaciones, a partir de hoy, dice Google. La implementación se completará en los próximos días. La compañía no ofreció un marco de tiempo para el soporte de la función para otras plataformas e idiomas, ni siquiera un compromiso firme de que dicho soporte llegaría en el futuro.

Además, YouTube dijo que ahora también comenzará a probar una función para los creadores que usan YouTube Studio para administrar su canal.

Los creadores podrán probar un nuevo filtro que ocultará los comentarios ofensivos e hirientes que se han retenido automáticamente para su revisión.

Hoy en día, los usuarios de YouTube Studio pueden elegir moderar automáticamente los comentarios potencialmente inapropiados, que luego pueden revisar manualmente y elegir aprobar, ocultar o informar. Si bien es útil mantenerlos, a menudo es difícil para los creadores tener que lidiar con estos comentarios, ya que los trolls en línea pueden ser increíblemente crueles. Con el filtro, los creadores pueden evitar por completo estos comentarios potencialmente ofensivos.

YouTube dice que también optimizará sus herramientas de moderación para facilitar el proceso de revisión en el futuro.

Los cambios siguen a un año durante el cual YouTube ha sido fuertemente criticado por no hacer lo suficiente para combatir el discurso de odio y la desinformación en su plataforma. El sistema de “advertencias” de la plataforma de videos por violaciones a las reglas significa que los videos pueden eliminarse individualmente, pero un canal en sí puede permanecer en línea a menos que recopile suficientes advertencias para ser eliminado. En la práctica, eso significa que un creador de YouTube podría ser tan violento como pedir que los funcionarios del gobierno sean decapitados y seguir usando YouTube. (En comparación, esa misma amenaza llevó a la prohibición de una cuenta en Twitter).

YouTube afirma que ha aumentado el número de eliminaciones diarias de comentarios de incitación al odio en 46 veces desde principios de 2019. Y en el último trimestre, de los más de 1.8 millones de canales que canceló por violar políticas, más de 54,000 cancelaciones fueron por incitación al odio. Eso indica un problema creciente con el discurso en línea que probablemente influyó en estas nuevas medidas. Algunos dirían que las plataformas tienen la responsabilidad de hacer aún más, pero es un equilibrio difícil.

En un movimiento separado, YouTube dijo que pronto presentará una nueva encuesta que pedirá a los creadores que compartan voluntariamente con YouTube información sobre su género, orientación sexual, raza y etnia. Con los datos recopilados, YouTube afirma que podrá examinar mejor cómo se trata el contenido de diferentes comunidades en los sistemas de búsqueda, descubrimiento y monetización.

También buscará posibles patrones de odio, acoso y discriminación que podrían afectar a algunas comunidades más que a otras, explica la empresa. Y la encuesta les dará a los creadores la opción de participar en otras iniciativas que organiza YouTube, como las reuniones de creadores #YouTubeBlack o FanFest, por ejemplo.

Esta encuesta comenzará en 2021 y fue diseñada en consulta con los aportes de creadores y expertos en derechos civiles y humanos. YouTube dice que los datos recopilados no se utilizarán con fines publicitarios, y los creadores podrán optar por no participar y eliminar su información por completo en cualquier momento.